Python PyWebIO提升团队效率使用介绍

目录

- 引言

- 简介

- Step one:本地文件上传

- Step two:风险值卡控

- Step Three: 标签卡控

- 总结

引言

Q&A快速了解PyWebIO

Q:首先,什么是PyWebIO?

A:PyWebIO提供了一系列命令式的交互函数,能够让咱们用只用Python就可以编写 Web 应用, 不需要编写前端页面和后端接口, 让简易的UI开发效率大大提高(本人非研发,用词可能不妥,大家轻点喷)

Q:其次,我们能用来干嘛?? 这对一个团队的效率提升有什么作用??

A:Pywebio的作用在于让咱们可以快速的开发一个带有UI界面的,支持用户输入的,以既定的逻辑输出结果的应用。 那么,我们是不是可以将团队内一些机械性的数据处理,数据异动分析等的工作以既定逻辑的方式通过Pywebio输出一个可复用的应用给大家使用呢? 当然,日常的数据运营过程中,咱们肯定不是面对着一成不变的case。 那么,我们是不是可以用不同参数输入的方式来达到一定的泛用性拓展呢? 只要,case和case之间的底层逻辑是一致的,我们就可以用同一套逻辑,不同的入参来达到不同结果输出的获取。

Exampl 倘若,我们每天都有一项工作,每天对着一份又一份业务反馈的订单,然后部门需要对着这些订单本身进行一个初步的风险分层,我们是不是可以把风险分层的底层规则写在后端,然后通过PywebIO来支持不同情况下的不同规则阈值输入, 快速获取咱们所需要的风险分层结果。 (当然,如果数据允许,直接写SQL也可以,可是,SQL需要一定的门槛,而PywebIO则可以通过UI的方式分享给那些没有技术背景的运营人员进行0代码使用。)

以下正式开始用一个例子来逐步介绍PywebIO拓展包

简介

虚拟背景: 每天需要一份又一份地对业务反馈的样本来进行风险分层,为了提高处理效率。

计划方案: 通过现有风险标签的波尔标签,非波尔标签体系来搭建一个支持 灵活配置阈值来快速获取分层结果的UI应用。

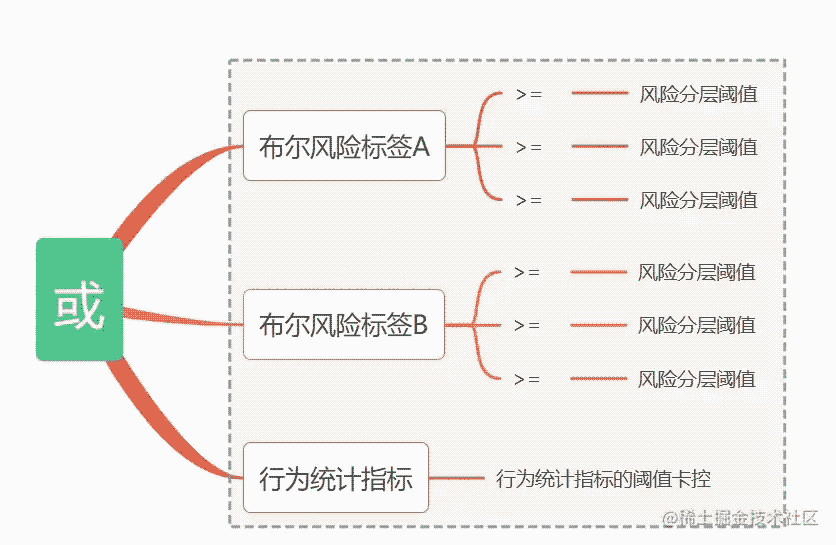

方案简介:基本逻辑如下,(以下均为举例所示,并不代表该方案就可以进行风险分层哈,大家请注意)

开始实现:这里的例子采取的是非数据库模式,支持的是上传本地csv,然后进行阈值配置。

Step one:本地文件上传

首先,肯定是得先文件上传的代码。

##例子如下:

import pandas as pd

from pywebio.input import *

from pywebio import start_server

from pywebio.output import *

import nest_asyncio

import numpy as np

import os

import time

nest_asyncio.apply()

import pandas as pd

from pywebio.input import *

from pywebio import start_server

from pywebio.output import *

import nest_asyncio

import numpy as np

import os

import time

nest_asyncio.apply()

def read_csv():

put_markdown('# 只支持pin')

put_markdown('功能如下:')

put_markdown("""

- 选择与程序再**同一文件夹**的文件

- 输入你希望卡的风险值阈值 **不输入则默认-10**

- 自动加载解析输出极黑标签占比以及明细数据

- 请勾选你所需要的标签**(不勾选=全选)**,然后点击提交即可

""")

file = file_upload('只支持上传该程序所在文件夹的csv文件哦', '.csv')

## 本地文件

raw_data = pd.read_csv(os.getcwd() + "\" + file['filename'], encoding='gbk')

put_html(raw_data.to_html())

if __name__ == '__main__':

start_server(read_csv, port=8081, debug=True, cdn=False, auto_open_webbrowser=True)

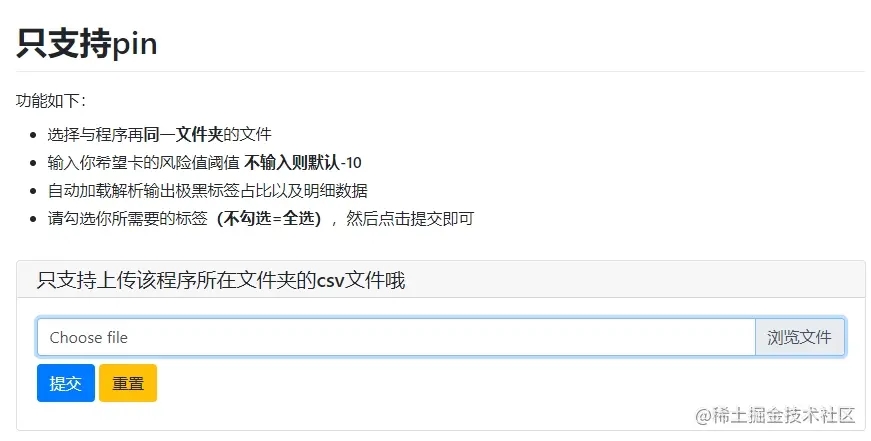

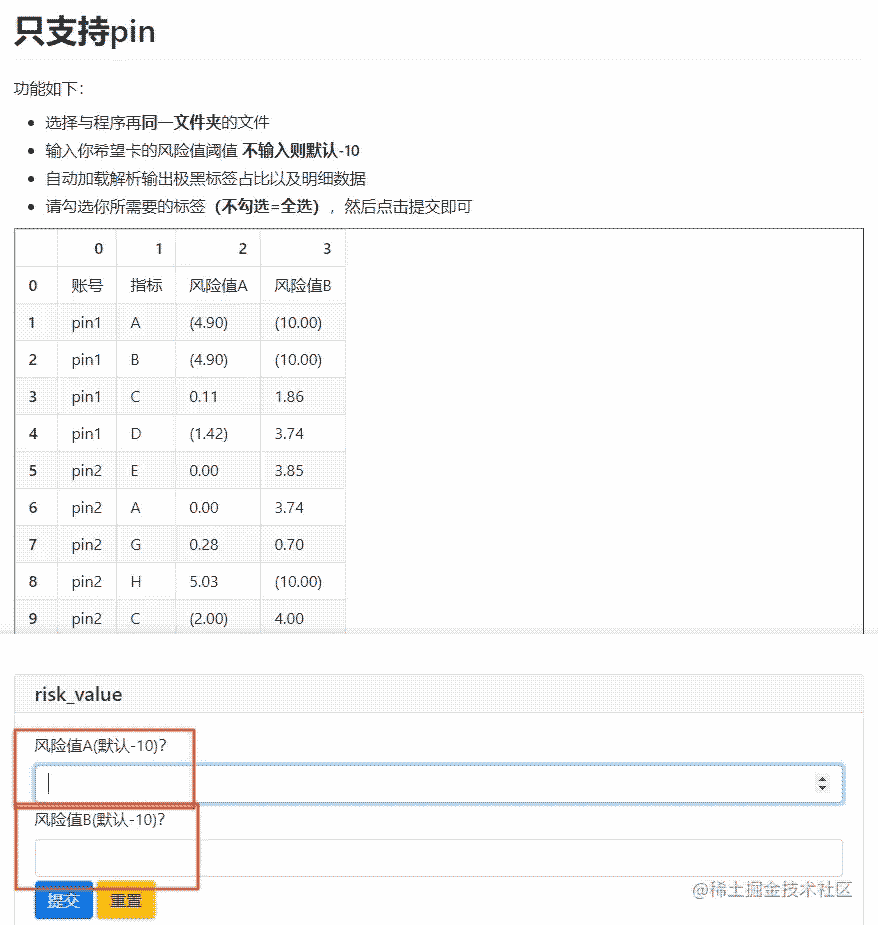

允许代码后,因为” auto_open_webbrowser=True“,所以自动弹出一个WebUI,如下左图,选择上传的文件,即可看到下右图的文件数据

Step two:风险值卡控

第一步也只是上传文件,展示文件,还没达到咱们的目的。 所以,第二步则是需要对上传的csv本身进行数据处理,逻辑判断。 这里其实很好理解,在step one 中已经获取了上传的文件且转成dataframe了对吧,那么实际,咱们只需要沿用咱们熟悉的pandans对dataframe进行处理即可。

import pandas as pd

from pywebio.input import *

from pywebio import start_server

from pywebio.output import *

import nest_asyncio

import numpy as np

import os

import time

nest_asyncio.apply()

def 配置规则_风险值阈值(df, user_risk, pp_risk=None):

df_updated = df[(df['风险值A'] >=user_risk)|((df['风险值B'] >=pp_risk))]

return df_updated

def read_csv():

put_markdown('# 只支持pin')

put_markdown('功能如下:')

put_markdown("""

- 选择与程序再**同一文件夹**的文件

- 输入你希望卡的风险值阈值 **不输入则默认-10**

- 自动加载解析输出极黑标签占比以及明细数据

- 请勾选你所需要的标签**(不勾选=全选)**,然后点击提交即可

""")

file = file_upload('只支持上传该程序所在文件夹的csv文件哦', '.csv')

## 本地文件

data = []

raw_data = pd.read_csv(os.getcwd() + "\" + file['filename'], encoding='gbk')

put_html(raw_data.to_html())

## -------------------------- 下面是 step two 新增的代码 --------------------------

risk_value = input_group(

"risk_value",

[

input("风险值A(默认-10)?", name="user_risk", type=NUMBER),

input("风险值B(默认-10)?", name="pp_risk", type=NUMBER)

],

)

raw_data_upated = 配置规则_风险值阈值(raw_data,risk_value['user_risk'], risk_value['pp_risk'])

table1 = raw_data_upated.groupby('指标').账号.count().reset_index()

table1['占比'] = table1.账号 / len(raw_data_upated.账号.unique()) * 100

table1.sort_values('占比', ascending=False, inplace=True)

put_html(table1.to_html())

## -------------------------- 上面是 step two 新增的代码 --------------------------

if __name__ == '__main__':

start_server(read_csv, port=8081, debug=True, cdn=False, auto_open_webbrowser=True)

Step Three: 标签卡控

从第二步,我们已经完成了风险值阈值的卡控,然后第三步就是标签的选取了。从对标签的理解和应用经验以及第二步得到的标签在样本中的占比,咱们就可以快速的知道,这个样本里面的标签分布分别是什么。进一步可以通过标签的选取达到最终符合我们风险分层结果中有风险的那一部分的输出了

import pandas as pd

from pywebio.input import *

from pywebio import start_server

from pywebio.output import *

import nest_asyncio

import numpy as np

import os

import time

nest_asyncio.apply()

def 配置规则_风险值阈值(df, user_risk, pp_risk=None):

df_updated = df[(df['风险值A'] >=user_risk)|((df['风险值B'] >=pp_risk))]

return df_updated

def read_csv():

put_markdown('# 只支持pin')

put_markdown('功能如下:')

put_markdown("""

- 选择与程序再**同一文件夹**的文件

- 输入你希望卡的风险值阈值 **不输入则默认-10**

- 自动加载解析输出极黑标签占比以及明细数据

- 请勾选你所需要的标签**(不勾选=全选)**,然后点击提交即可

""")

file = file_upload('只支持上传该程序所在文件夹的csv文件哦', '.csv')

## 本地文件

data = []

raw_data = pd.read_csv(os.getcwd() + "\" + file['filename'], encoding='gbk')

put_html(raw_data.to_html())

risk_value = input_group(

"risk_value",

[

input("风险值A(默认-10)?", name="user_risk", type=NUMBER),

input("风险值B(默认-10)?", name="pp_risk", type=NUMBER)

],

)

raw_data_upated = 配置规则_风险值阈值(raw_data,risk_value['user_risk'], risk_value['pp_risk'])

table1 = raw_data_upated.groupby('指标').账号.count().reset_index()

table1['占比'] = table1.账号 / len(raw_data_upated.账号.unique()) * 100

table1.sort_values('占比', ascending=False, inplace=True)

put_html(table1.to_html())

## -------------------------- 下面是 step three 新增的代码 --------------------------

set_list = raw_data_upated.指标.unique()

list_save = checkbox(label='勾选保留的标签,不勾选=全选', options=set_list, inline=True)

if list_save == []:

list_save = set_list

else:

list_save = list_save

raw_data_upated = raw_data_upated[raw_data_upated.指标.isin(list_save)]

put_html(raw_data_upated.to_html())

def Save0():

put_markdown("You click Save button, Done").show()

raw_data_upated.to_excel(os.getcwd() + "\" + '输出的风险明细.xlsx', index=False)

put_markdown("find your file on 程序同级文件夹下的 文件 : 输出的风险明细.xlsx").show()

put_buttons(['下载文件"对内不对外输出明细.xlsx"'], onclick=[Save0]).show()

## -------------------------- 上面是 step three 新增的代码 --------------------------

if __name__ == '__main__':

start_server(read_csv, port=8081, debug=True, cdn=False, auto_open_webbrowser=True)

总结

这里只是举了个简单的例子,一个支持阈值+标签卡控,快速获取符合要求的目标群体的例子。 实际上,这个框架的拓展还有很多。例如:

1.直连数据库,可以帮住那些不会sql的同事可以自定义快速获取业务数据。

2.Pyinstaller封装成本地程序,脱离代码环境,可以在任意电脑,任意环境,任意人士进行使用,有兴趣的同学可以看《Python-Pyinstaller介绍》

以上就是Python PyWebIO提升团队效率使用介绍的详细内容,更多关于Python PyWebIO效率提升的资料请关注我们其它相关文章!