利用python实时刷新基金估值(摸鱼小工具)

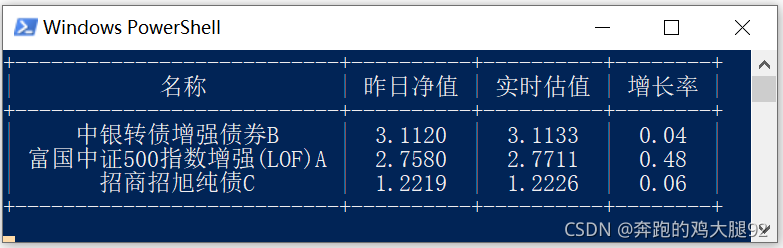

摸鱼小工具_利用python实时刷新基金估值 效果预览

上源码

import requests

import json

import os

from prettytable import PrettyTable

import time

fundlist = ['163817','161017','003860']

def GetFundJsonInfo(fundcode):

url = "http://fundgz.1234567.com.cn/js/"+fundcode+".js"

response = requests.get(url)

fundDataInfo = response.text.split('({')[1]

fundDataInfo = '{'+ fundDataInfo.split('})')[0] + '}'

fundDataInfo = json.loads(fundDataInfo)

return fundDataInfo

os.system("cls")

while True:

table = PrettyTable(["名称","昨日净值","实时估值","增长率"])

for fund in fundlist:

myfund = GetFundJsonInfo(fund)

table.add_row([myfund['name'],myfund['dwjz'],myfund['gsz'],myfund['gszzl']])

print(table)

time.sleep(5)

os.system("cls")

说明

- prettytable 通过表格格式化打印基金数据便于浏览数据

- os.system(“cls”) 用于清屏刷新

- 原始的响应内容

jsonpgz({"fundcode":"163817","name":"中银转债增强债券B","jzrq":"2021-09-10","dwjz":"3.1120","gsz":"3.1127","gszzl":"0.02","gztime":"2021-09-13 14:54"});

到此这篇关于利用python实时刷新基金估值(摸鱼小工具)的文章就介绍到这了,更多相关python基金估值内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

相关推荐

-

python 简单的股票基金爬虫

项目地址 https://github.com/aliyoge/fund_crawler_py 所用到的技术 IP代理池 多线程 爬虫 sql 开始编写爬虫 1.首先,开始分析天天基金网的一些数据.经过抓包分析,可知: ./fundcode_search.js包含所有基金代码的数据. 2.根据基金代码,访问地址: fundgz.1234567.com.cn/js/ + 基金代码 + .js可以获取基金实时净值和估值信息. 3.根据基金代码,访问地址: fundf10.eastmoney.com/

-

Python多进程方式抓取基金网站内容的方法分析

本文实例讲述了Python多进程方式抓取基金网站内容的方法.分享给大家供大家参考,具体如下: 在前面这篇//www.jb51.net/article/162418.htm我们已经简单了解了"python的多进程",现在我们需要把抓取基金网站(28页)内容写成多进程的方式. 因为进程也不是越多越好,我们计划分3个进程执行.意思就是 :把总共要抓取的28页分成三部分. 怎么分呢? # 初始range r = range(1,29) # 步长 step = 10 myList = [r[x:

-

Python批量获取基金数据的方法步骤

20年初准备投资基金,想爬取基金的业绩数据. 20年基金迎来了爆发式增长,现把代码开源以供参考. 本代码只能实现初步汇总,输出csv文件来保存基金的单位&累计净值,后期仍需要结合统计方法来筛选优质基金. 参考了网上的部分代码,实在不记得出处了,侵删. import requests import time import execjs start = time.perf_counter() # 获取所有基金编号 def getAllCode(): url = 'http://fund.eastmo

-

Python获取基金网站网页内容、使用BeautifulSoup库分析html操作示例

本文实例讲述了Python获取基金网站网页内容.使用BeautifulSoup库分析html操作.分享给大家供大家参考,具体如下: 利用 urllib包 获取网页内容 #引入包 from urllib.request import urlopen response = urlopen("http://fund.eastmoney.com/fund.html") html = response.read(); #这个网页编码是gb2312 #print(html.decode("

-

Python学习笔记之抓取某只基金历史净值数据实战案例

本文实例讲述了Python抓取某只基金历史净值数据.分享给大家供大家参考,具体如下: http://fund.eastmoney.com/f10/jjjz_519961.html 1.接下来,我们需要动手把这些html抓取下来(这部分知识我们之前已经学过,现在不妨重温) # coding: utf-8 from selenium.webdriver.support.ui import WebDriverWait from selenium import webdriver from bs4 im

-

利用python实时刷新基金估值(摸鱼小工具)

摸鱼小工具_利用python实时刷新基金估值 效果预览 上源码 import requests import json import os from prettytable import PrettyTable import time fundlist = ['163817','161017','003860'] def GetFundJsonInfo(fundcode): url = "http://fundgz.1234567.com.cn/js/"+fundcode+"

-

利用python实时刷新基金估值效果(摸鱼小工具)

摸鱼小工具_利用python实时刷新基金估值 效果预览 上源码 import requests import json import os from prettytable import PrettyTable import time fundlist = ['163817','161017','003860'] def GetFundJsonInfo(fundcode): url = "http://fundgz.1234567.com.cn/js/"+fundcode+"

-

利用Python实时获取steam特惠游戏数据

目录 前言 代码部分 开发环境 先导入本次所需的模块 请求数据 获取请求的数据 解析数据 保存数据 前言 Steam是由美国电子游戏商Valve于2003年9月12日推出的数字发行平台,被认为是计算机游戏界最大的数码发行平台之一,Steam平台是全球最大的综合性数字发行平台之一.玩家可以在该平台购买.下载.讨论.上传和分享游戏和软件. 而每周的steam会开启了一轮特惠,可以让游戏打折,而玩家就会购买心仪的游戏 传说每次有大折扣,无数的玩家会去购买游戏,可以让G胖亏死 不过,由于种种原因,我总会

-

利用Python写了一个水果忍者小游戏

目录 前言: 一.需要导入的包 二.窗口界面设置 三.随机生成水果位置 四.绘制字体 五.玩家生命的提示 六.游戏开始与结束的画面 七.游戏主循环 最后 前言: 水果忍者到家都玩过吧,但是Python写的水果忍者你肯定没有玩过.今天就给你表演一个新的,用Python写一个水果忍者.水果忍者的玩法很简单,尽可能的切开抛出的水果就行. 今天就用python简单的模拟一下这个游戏.在这个简单的项目中,我们用鼠标选择水果来切割,同时炸弹也会隐藏在水果中,如果切开了三次炸弹,玩家就会失败. 一.需要导入的

-

如何利用Python给自己的头像加一个小国旗(小月饼)

今年国庆节也是中秋节,首先祝大家节日快乐,本文我们使用 Python 来给自己的头像加一个小国旗或小月饼. 国旗 对于国旗,我们可以使用 Python 来画一个,用到的 Python 库是大家比较熟悉的 turtle,我们的五星红旗组成元素包括:红底.一颗黄的主星和四颗黄的副星. 首先画一个长方形的红底,代码实现如下: turtle.setup(600, 400, 0, 0) turtle.bgcolor("red") 效果如下: 接着画一颗主星,代码实现如下: turtle.fill

-

Python基于tkinter模块实现的改名小工具示例

本文实例讲述了Python基于tkinter模块实现的改名小工具.分享给大家供大家参考,具体如下: #!/usr/bin/env python #coding=utf-8 # # 版权所有 2014 yao_yu # 本代码以MIT许可协议发布 # 文件名批量加.xls后缀 # 2014-04-21 创建 # import os import tkinter as tk from tkinter import ttk version = '2014-04-21' app_title = '文件名

-

Python 制作查询商品历史价格的小工具

一年一度的双十一就快到了,各种砍价.盖楼.挖现金的口令将在未来一个月内充斥朋友圈.微信群中.玩过多次双十一活动的小编表示一顿操作猛如虎,一看结果2毛5.浪费时间不说而且未必得到真正的优惠,双十一电商的"明降暗升"已经是默认的潜规则了.打破这种规则很简单,可以用 Python 写一个定时监控商品价格的小工具. 思路 第一步抓取商品的价格存入 Python 自带的 SQLite 数据库 每天定时抓取商品价格 使用 pyecharts 模块绘制价格折线图,让低价一目了然 抓取京东价格 从商品

-

用python开发一款操作MySQL的小工具

项目地址 https://github.com/lishukan/directsql 安装 pip3 install directsql 导入 directsql 目前只提供三个外部类 __all__=["SqlGenerator","MysqlConnection","MysqlPool"] 导入方式 from directsql.sqlgenerator import SqlGenerator #该类用于生成sql语句 #下面是一个池化连接对

-

Python自制一个PDF转PNG图片小工具

使用PyQt5应用程序制作PDF转换成图片的小工具,可以导入PDF文档后一键生成对应的PNG图片. PDF图片转换小工具使用的中间件: python版本:3.6.8 UI应用版本:PyQt5 PDF文件操作非标准库:PyPDF2 PNG图片生成库:PyMuPDF pip install PyQt5 pip install PyPDF2 pip install PyMuPDF==1.18.17 将需要使用到的python标准库或非标准库全部导入到我们的代码块中进入开发环节. # Importing

-

python实现读取excel写入mysql的小工具详解

Python是数据分析的强大利器 利用Python做数据分析,第一步就是学习如何读取日常工作中产生各种excel报表并存入数据中,方便后续数据处理. 这里向大家分享python如何读取excel,并使用Python将数据存入Mysql中,有需要的朋友们一起来看看吧. 背景 需要导入全国高校名录到数据库,从教委网站下到了最新的数据,是excel格式,需要做一个工具进行导入,想试用一下python,说干就干. 库 xlrd : excel读写库 pymysql : mysql数据库驱动库,纯pyth

随机推荐

- Android应用开发SharedPreferences存储数据的使用方法

- Python使用arrow库优雅地处理时间数据详解

- jsp fckeditor 上传中文图片乱码问题的解决方法

- 用Vue.js实现监听属性的变化

- 解析JavaScript实现DDoS攻击原理与保护措施

- Python学习笔记之常用函数及说明

- window.onload追加函数使用示例

- 获取当前url

- 生成多字段排序分页的SQL的通用类

- 浅谈php和js中json的编码和解码

- CI框架在CLI下执行占用内存过大问题的解决方法

- 既简单又安全的PHP验证码 附调用方法

- PHP创建文件,并向文件中写入数据,覆盖,追加的实现代码

- 利用forever和pm2部署node.js项目过程

- jQuery学习笔记 操作jQuery对象 属性处理

- Jquery easyUI 更新行示例

- 十个习惯让你精通新的开发技术

- VC自定义消息响应函数postmessage用法示例

- Android编程实现手机拍照的方法详解

- 详解React 在服务端渲染的实现